Ce qu’il faut retenir…

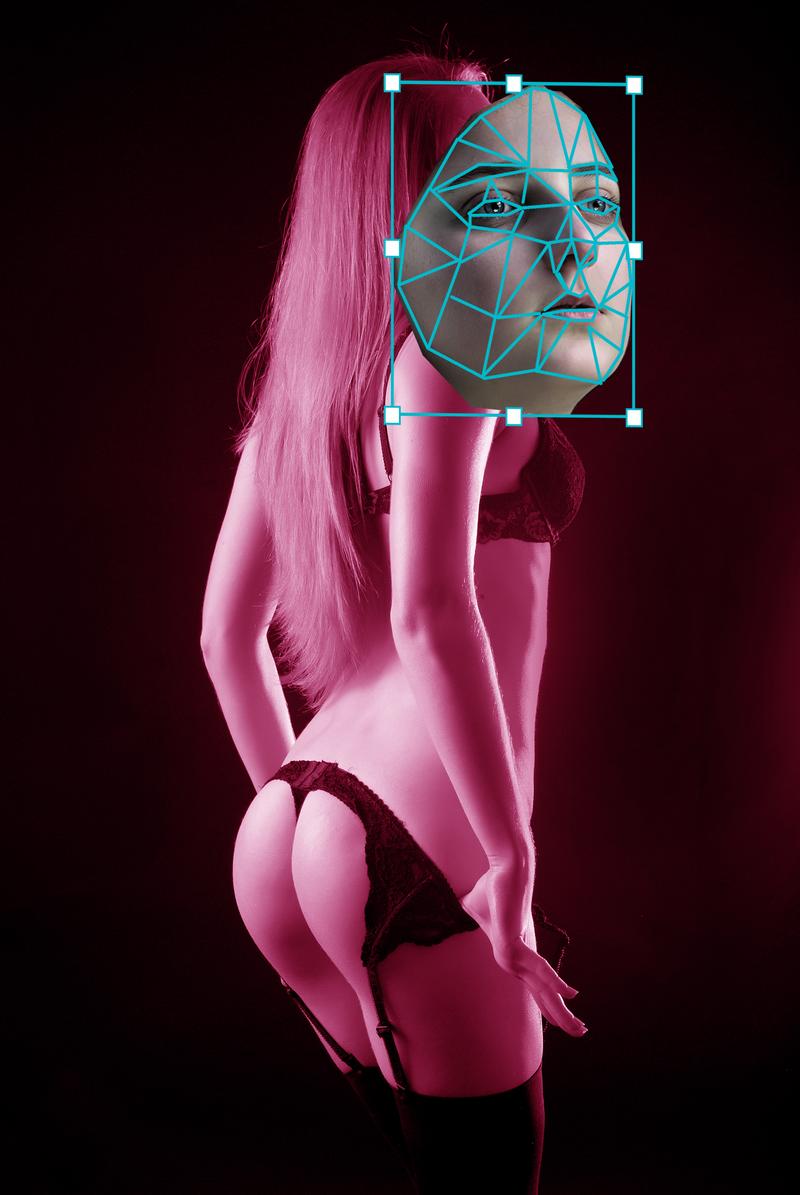

En nous intéressant aux facteurs qui contribuent à la propagation des deepfakes, 3 composantes typiques peuvent être identifiées :

- L’hypervisibilité : si les logiciels de trucage numérique sont aujourd’hui faciles d’utilisation, la réalisation d’une vidéotox doit cependant pouvoir s’appuyer sur un nombre important d’images et de vidéos en ligne pour se rapprocher le plus possible d’un certain réalisme. Cette injonction de visibilité ne peut se dissocier de celle de modernité (le fait d’être en phase avec l’actualité, d’être à la mode, de correspondre à une tendance récente), et contribue considérablement à sa propagation sur la toile. Ainsi, plus la personne est populaire et référencée sur internet, plus elle est susceptible de faire l’objet d’un deepfake.

- L’exclusivité : plusieurs études et rapports (Institut Reuters, European journalism observatory) montrent que les sources officielles suscitent aujourd’hui une certaine défiance de la part du grand public (crédibilité des journalistes remise en question, moyens d’information traditionnels boudés par les jeunes générations, etc.). Sont au contraire privilégiés sur internet des sources alternatives (Ducol ; 1997) qui se focalisent sur la révélation, l’exclusivité, le scoop (comme la source d’un témoin de l’affaire, un proche du dossier, etc.).

- L’émotion : un lien fondamental est établi entre l’émotion mémorisable et le pouvoir de l’image (Barre ; 2020). Ainsi une vidéo à caractère sexuel, perçue dans sa dimension transgressive du tabou, est un élément porteur de sensations pour le spectateur. L’évocation de l’interdit procure des émotions contradictoires pour celui qui regarde, entre l’offense faite à son système de valeurs et la réjouissance par procuration à franchir les limites de cet intime. “L’information ne cherche pas ici un savoir ni même un voir, mais un faire-voir susceptible de produire directement un croire, indispensable à l’émotion” (Têtu ; 2004).